先明确去重规则并选择安全操作方式,再同步验证。1. 按主键、唯一索引或业务字段确定重复逻辑,用ROW_NUMBER()等保留最新记录;2. 大表推荐重建表结构,加唯一约束后INSERT IGNORE并原子替换;3. 主从同步依赖ROW格式Binlog,避免延迟,手动同步需导出导入并校验;4. 完成后检查行数、字段完整性,保留备份支持回滚。全过程需备份、低峰操作、分步测试以保障一致性与服务稳定。

在mysql中进行去重后,数据同步通常是指将去重后的结果更新到原表或同步到其他系统(如从库、数据仓库等)。这个过程需要保证数据一致性、避免重复处理,并尽量减少对线上服务的影响。以下是常见的操作流程和注意事项。

1. 确认去重逻辑与目标

去重前需明确依据哪些字段判断重复,比如主键冲突、唯一索引重复,还是业务字段组合(如手机号+姓名)重复。常见去重方式包括:

- 保留最早/最晚的一条记录:通过时间戳或自增ID筛选

- 按特定字段合并:如状态取最新值

- 使用窗口函数去重:如ROW_NUMBER()分区排序

示例:保留每个用户最近的一条记录

select * FROM ( SELECT *, ROW_NUMBER() OVER (PARTITION BY user_id ORDER BY update_time DESC) AS rn FROM user_info ) t WHERE rn = 1;

2. 去重操作实施方式

根据是否修改原表,分为“原地去重”和“导出重建”两种模式。

方案一:原表直接删除重复数据

- 创建临时标记表或使用CTE定位重复行

- 保留一条,删除其余

delete t1 FROM user_info t1 INNER JOIN user_info t2 WHERE t1.id

方案二:重建表结构(推荐大表使用)

- 创建新表,带唯一约束

- 插入去重后数据

- 原子替换原表(RENAME)

CREATE table user_info_clean LIKE user_info; ALTER TABLE user_info_clean ADD UNIQUE KEY uk_user (user_id); INSERT IGNORE INTO user_info_clean SELECT * FROM user_info ORDER BY update_time DESC; RENAME TABLE user_info TO user_info_backup, user_info_clean TO user_info;

3. 同步去重后数据到其他节点

如果涉及主从架构或跨库同步,需确保去重操作能正确传播。

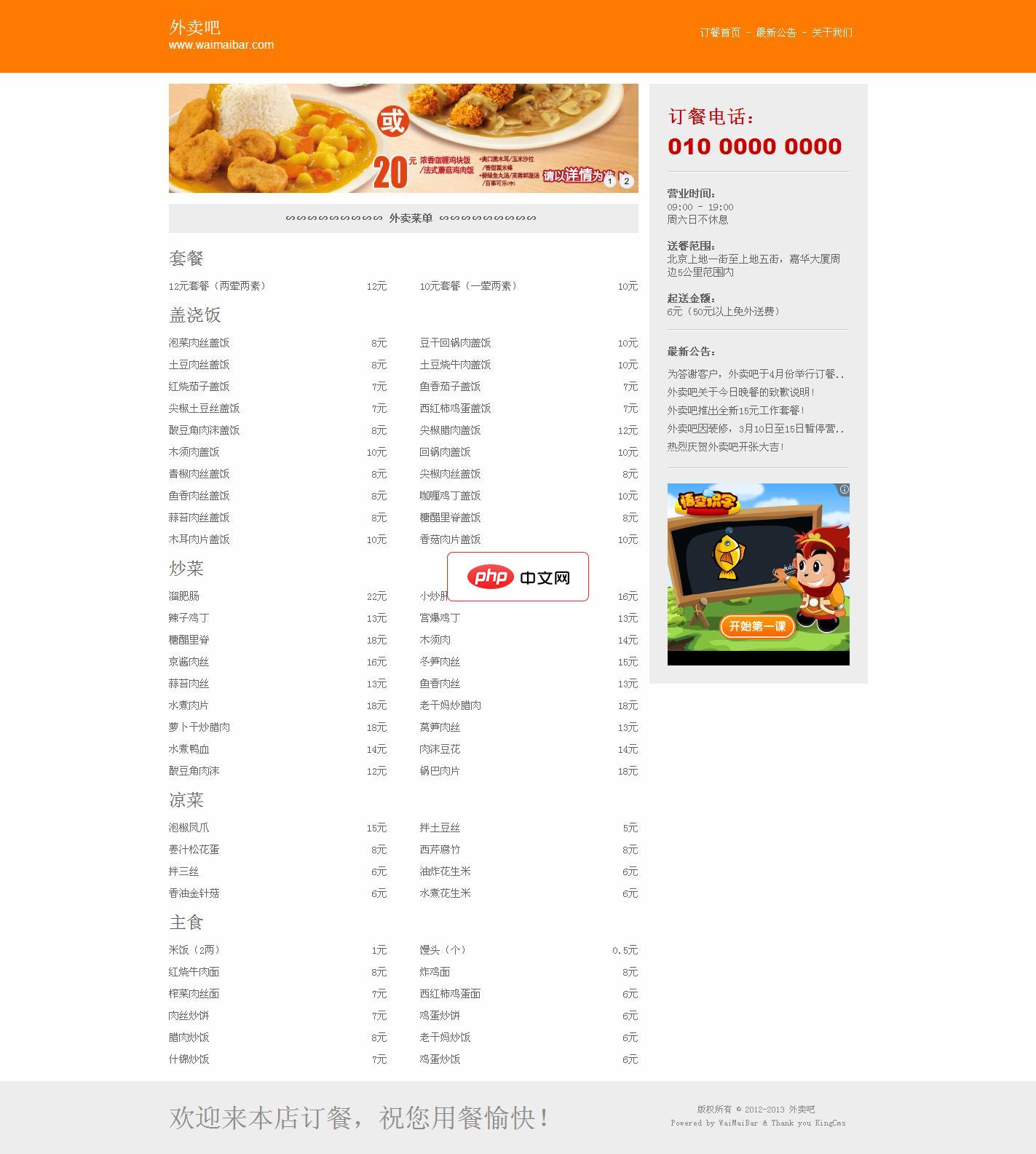

一、本站采用PHP+mysql,核心程序使用了kingcms PHP版,重新设计了模板界面,增加了一些操作功能,方便外卖同行可以很好的展示宣传自己的外卖产品。本套源码的模板可以随意共享传播,程序版权仍归Kingcms所有。 二、网站部署操作: 第一步:将“upload”文件夹的所有文件上传到网站的根目录下。 第二步:在数据库管理后台创建好数据库并将源码中的“mysql”文件夹里的文件导入到数据库中

0

0 基于Binlog的同步场景:

- 使用

ROW格式日志可准确复制DELETE/INSERT行为 - 避免使用影响多行的语句导致延迟或不一致

- 建议在低峰期执行,监控从库延迟

手动同步场景(如etl任务):

- 将去重后的数据导出为SQL或csv

- 在目标库先清空或软删除旧数据

- 导入新数据并校验行数与关键指标

4. 数据校验与回滚准备

完成去重和同步后必须验证结果。

- 检查目标表记录数是否符合预期

- 抽样比对关键字段是否完整

- 确认索引、外键等约束仍有效

- 保留备份表一段时间(如7天),以便快速恢复

必要时可通过备份表还原:

RENAME TABLE user_info TO user_info_bad, user_info_backup TO user_info;

基本上就这些。核心是先明确去重规则,选择安全的操作方式,再稳妥同步并验证结果。尤其在线上环境,务必提前备份,分步测试。